此文章只用于作者分享学习经历,如有侵权或不当的地方请联系本人删除,邮箱:875591584@qq.com

注:超简单的爬虫实例,想学python 爬虫的小伙伴可以参考参考。第一次写博客,还请多多包涵

—————————————————————————————————

一、环境准备

python3的安装请自行百度,编辑器我用的pycharm,如果自己喜欢其他的编辑器,如jupyter等

二、用到的库

1、requests

在命令行使用pip安装命令:pip install request

在py文件里导入:import requests

2、re

方法同上

3、BeautifulSoup

导入:from bs4 import BeautifulSoup

三、每个库对应用到的方法

1、requests

只用到了最基础的requests.get()方法

2、re

使用了re.compile()这个方法

3、BeautifulSoup

BeautifulSoup()对夺取到的html或xml进行解析

四、简单分析

如何打开浏览器开发者工具–>f12或者右击然后检查元素(还有意外的自行百度)

目标网址:宠物页面链接

对页面html元素的分析( 以烈火战胜为例)(图片)

看到右边的蓝字部分,把鼠标放到src就可以看到图片,此链接为图片的下载链接,再看到alt标签,表示的是宠物的名字。我们要的就是这两个东西,我们要得到src链接获取图片,然后用相应的alt作为它的名字

看到右边的蓝字部分,把鼠标放到src就可以看到图片,此链接为图片的下载链接,再看到alt标签,表示的是宠物的名字。我们要的就是这两个东西,我们要得到src链接获取图片,然后用相应的alt作为它的名字

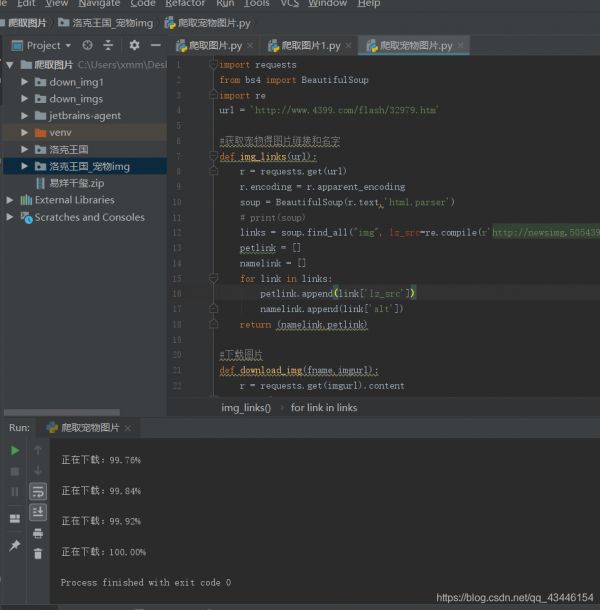

五、代码

只为达到目的,代码不漂亮,轻喷

我的注释写的比较详细,如果有问题可以在博客下面评论或者通过邮箱联系我

import requests from bs4 import BeautifulSoup import re url = 'http://www.4399.com/flash/32979.htm' #获取宠物得图片链接和名字 def img_links(url): #requests.get()方法得到页面html r = requests.get(url) #改变编码使之与原网页一样,否则可能会出现乱码,后面的步骤也无法进行 r.encoding = r.apparent_encoding #BeautifulSoup()解析html soup = BeautifulSoup(r.text,'html.parser') # print(soup) #使用正则表达式得到含有图片链接和名字的<img>标签 links = soup.find_all("img", lz_src=re.compile(r'http://newsimg.5054399.com/uploads/userup/d+/w+.gif')) petlink = [] namelink = [] #使用for循环把图片链接与名字分别写入 for link in links: petlink.append(link['lz_src']) namelink.append(link['alt']) return (namelink,petlink) #下载图片 def download_img(fname,imgurl): #requests.get(url).content表示获取页面的内容(此处就得到了图片) r = requests.get(imgurl).content with open(r'C:UsersxmmDesktop爬取图片洛克王国%s.gif'%fname,"wb") as f: f.write(r) name,img = img_links(url) idx = 0 for imgurl in img: download_img(name[idx],imgurl) idx+=1 print('正在下载:{:.2f}%'.format(100*idx/1269))

123456789101112131415161718192021222324252627282930313233343536运行效果

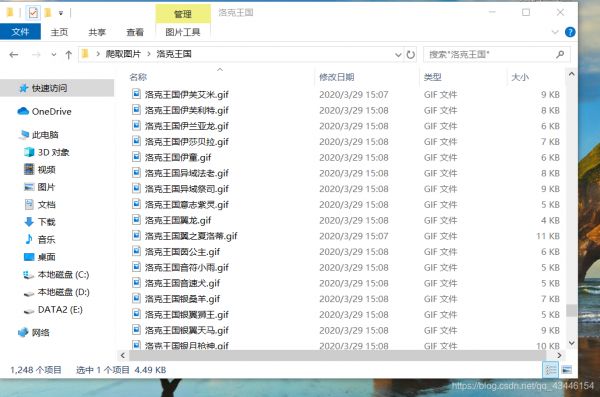

照片文件夹展示