PPO控制人形机器人行走举例

最新推荐文章于 2024-10-12 21:57:12 发布

青瓜先生 于 2024-07-06 11:24:55 发布

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

37 篇文章 15 订阅 ¥69.90 ¥99.00

PPO控制人形机器人行走

Proximal Policy Optimization (PPO) 是一种策略优化算法,在强化学习中广泛使用。它通过改进策略梯度方法,使得训练过程更加稳定和高效。

PPO算法原理介绍

PPO算法主要有两种变体:PPO-Clip 和 PPO-Penalty。这里主要介绍PPO-Clip,因为它更常用。

主要思想 PPO通过限制策略更新的幅度来保持训练的稳定性。它引入了一个裁剪操作,限制新旧策略之间的变化。这种方法结合了信赖域策略优化 (TRPO) 的优点,但实现更加简单。

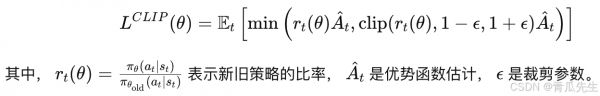

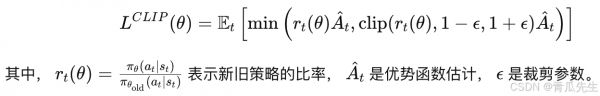

目标函数 PPO-Clip的目标函数如下:

案例:使用PPO算法控制人形机器人行走

方法 1、环境搭建: 使用MuJoCo(Multi-Joint dynamics with Contact)作为物理引擎,搭建人形机器人在平地上的行走环境。MuJoCo能够精确地模拟物理

相关知识

两足拉车机器人行走部分的设计【含7张CAD图】

王苑|具身智能体的隐私风险及法律应对——以“人形机器人”为例的展开

使用机器人步态训练器评估行走能力:脊髓损伤中按需辅助控制的机会和局限性,Journal of NeuroEngineering and Rehabilitation

宠物监控机器人拆解:创意拔高国产芯的天花板

智慧城市宠儿——智能机器人

人形机器人独角兽入局千亿宠物智能赛道

狗都有机器人陪伴了,你呢?狗狗伴侣Oro

2024世界机器人大会昨日开幕 智能机器人“十八般武艺”耍起来

深圳机器人,太“秀”了!

从人与机器人的互动来看移情效应

网址: PPO控制人形机器人行走举例 https://m.mcbbbk.com/newsview382222.html